購入して2年?ほど使っているNASが故障し、アクセスできなくなりました。電源を投入すると、LEDが赤点滅する状態でした。これを使えるようになんとか復旧してみましょう。

分解前チェック(LS210D0401G)

具体的な症状はつぎのとおり、電源スイッチをONにすると、最初LEDが白色点滅、そしてHDDがスピンアップする周波数が上がる音、それに続いてリトラクト音のあとスピンダウンして、静かになる。その後、数秒してLEDは赤色7回点滅にかわり、その後、7回点滅が繰り返されます。5分程度待っても赤色7回点滅のまま変わりません。

HDDは故障しているかどうかは微妙な感じだが、少なくともクラッシュしている音ではない。

電源OFFにすると、LEDは白色点滅のまま、2分以上たっても白色点滅のまま変わらないので、仕方なく電源プラグを抜いて強制停止するしかありません。

ACアダプタ電源については、他のNASで正常稼働しているアダプタと交換してみましたが、状況に変わりまありませんでした。

LANのリンクランプは電源プラグを挿している間は緑点滅しています。が、固定設定したIPへのPINGは応答がありません。もちろんWeb管理画面にはアクセスできません。また、BUFFALO NAS Navigator2でも見つけられません。

電源投入と電源OFFの動画です。

※電源投入直後のLAN挙動は、製品挙動の理解には参考になるが、NAS復活には意味がないので、やっていません。

HDD交換しても治りそうにないかどうかの判断を、どこかでする必要がありますが、今の段階では、判断できるネタがありません。また、このNASは、NAS全体で多重化しており、お金を払ってまで復旧する必要があるデータはありません。なので、つぎは分解調査に移行します。

※どうしても復旧したいデータがあればデータ復旧サービスを使って復旧させましょう。ちなみに、以前データ回収用のシェアウェアを公開してました。

NASの分解調査

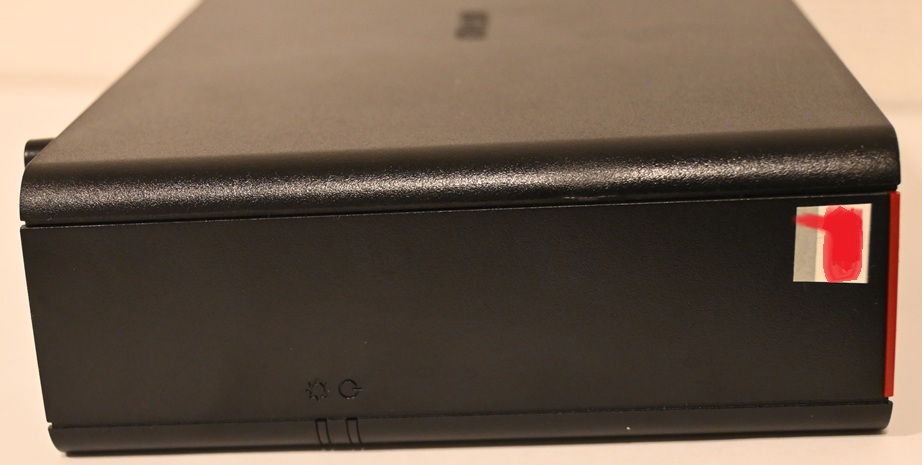

分解ですが、ゴム足の下にはねじはない。シールの下にはねじはなさそうです。

背面パネルと全面パネルは別パーツだが、隙間などは特に見えない。すくなくとも背面はコネクタやスイッチ類があるのでスライドさせてはめ込むような構造にはなっていない。

NAS前面

NAS背面(後面)

NAS上面

NAS下面

NAS左面 右面

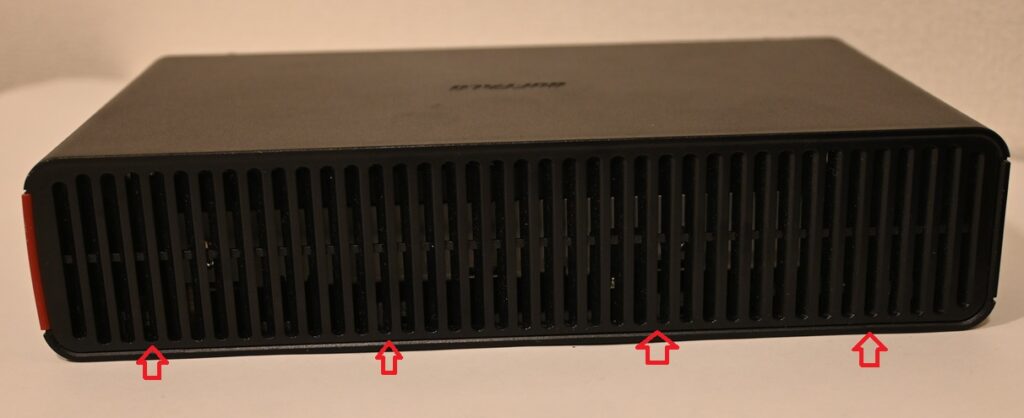

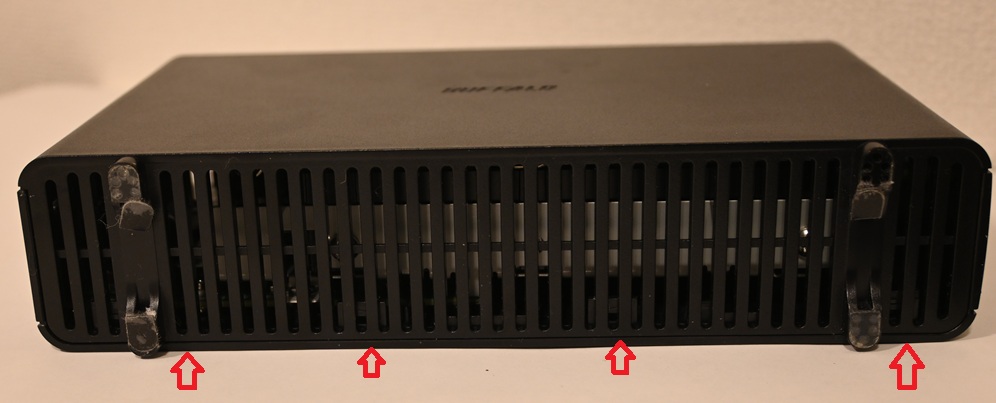

前面の下側に少し隙間があり、少しこじ開けると左右に爪があるように見える。しかし、前面パネルの右側は側面パネルと一体のようにも見える

実際には右面・前面・後面が一体 、左面・下面・上面が一体という構造になっていました。この2つのコの字のカバーを組み合わせる構造でした。

右側の足の中に締め殺し?のネジがあるようです。これをはずして、上の写真のつめを順に外して、抜いていくと分解できます。

結構傷はついてしまうでしょうが。。。

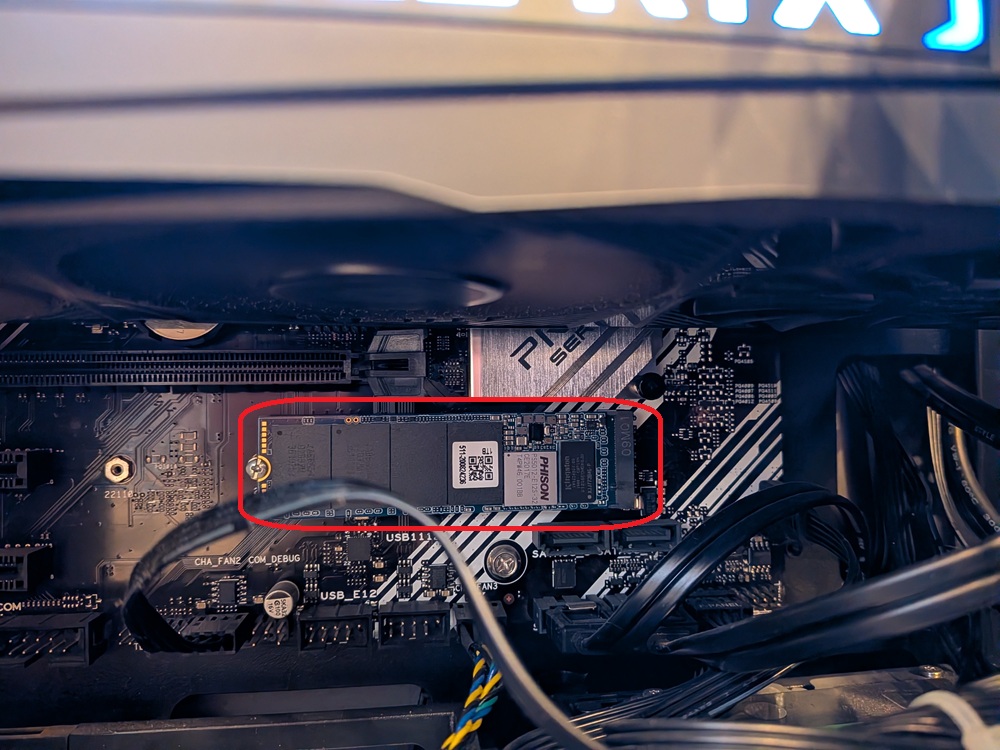

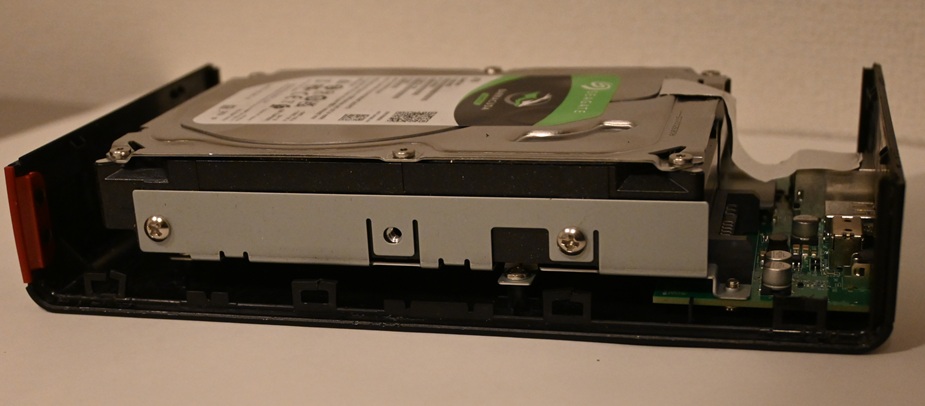

分解後のHDDの調査

型番を確認します。型番 は、ST4000DM005でした。

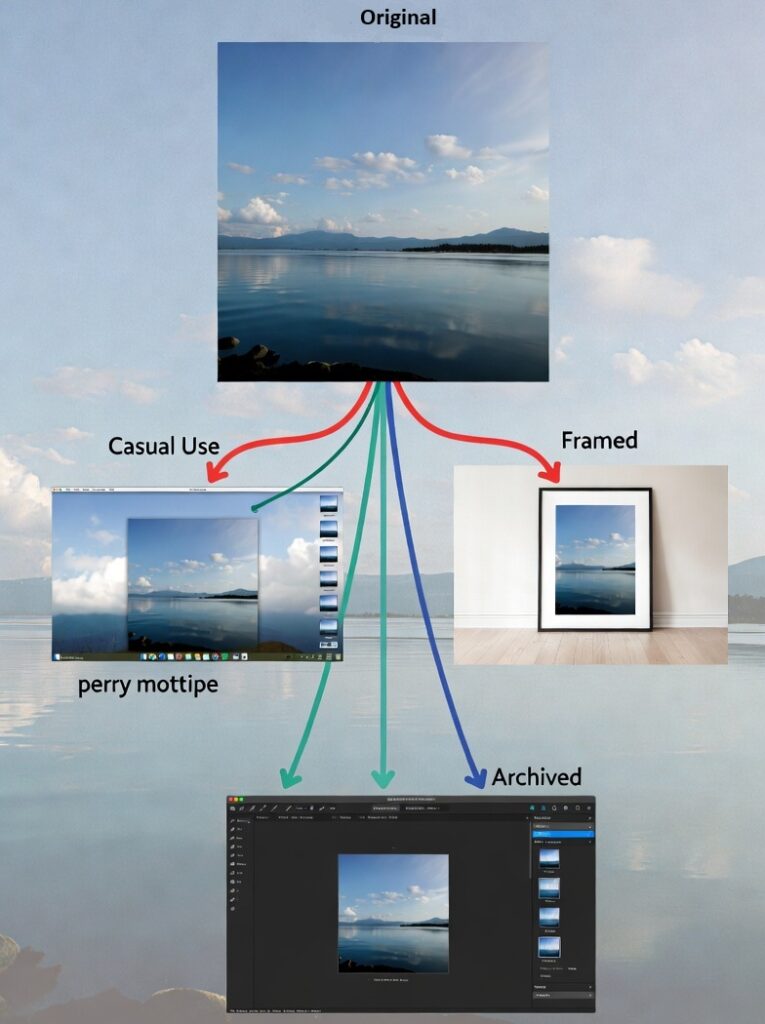

hsBoxのデータ救出機能を使ってデータを取れるか試してみます。情報によるとLS210DはExt4でフォーマットされているようなので、マウントできれば普通に読める可能性はあります。

残念ながら、NAS分解して取り出したHDDは、調査用のPCでは認識できず、マウントまでたどり着けませんでした。 取り出したHDDの調査は別途行いましょう。

交換用のHDDの選択

あえていろいろチャレンジしてみようかと思います。NASに使えなくてもデスクトップ内蔵の追加ドライブには使えるので、6TBに挑戦してみましょう。

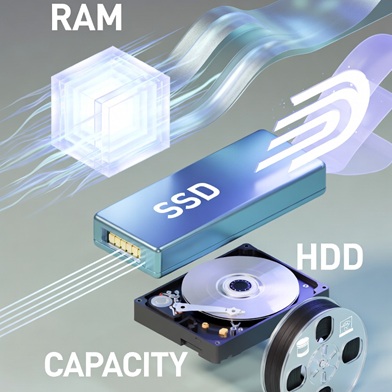

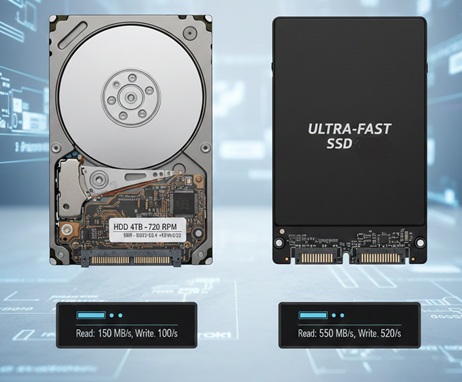

このNASで使用していたのは、ST4000DM005でした。これはSMRでした。CMRのドライブに変えるか?。という話になりますが、そもそも、SMRとCMRってなにってことになりますよね。その2つについて検討してみましょう。

SMRとCMRの違いって何?

この違いは、FlashとHDDの特性の違いくらいの違いがあります。理解したうえで使えば問題ないのでしょうが、知らずに使って原因がよくわからないトラブルが頻発していたりしないでしょうか?

パーツショップなどでは、SMRかCMRかは明記されていないケースがほとんどです。HDDは容量と値段だけで選んでいませんか? あと静音や熱か速度を気にして回転数で選ぶくらいでしょうか? SMRかCMRかを考慮して選んでいまますか?

CMR(Conventional Magnetic Recording)は昔ながらの書き込み方式で、隣のトラックに影響がないように書き込むトラック間隔を設計した方式です。それに対してSMR(Shingled Magnetic Recording)は、書き込むトラックの順番を限定することで、隣のトラックへの被せ書きを許容してトラック密度を上げる設計をした方式です。

SSDと同じような感じで、技術的な説明が利用者には正しく伝えられていないので、理解できないまま不適切な使い方をしているかもしれません。

SMRのメリットは、記録密度が上がるので、容量単価を下げられる。要するにお安く手に入れることができるということです。

その反面、書き込み順に制限があるため、書き換え・ランダムな書き込みに弱い、といったデメリットがあります。

PCの外部記憶用のNASであればランダムな書き込みや上書き更新は当たり前のように発生するので、CMRのほうがよいでしょう。

参考:SMR?CMR?HDDの書き込み方式は2種類

CMRとSMRの違いとは?HDD選びで失敗しない解説と比較ポイント

Multi-Tier Caching Technology

💰 ② 記録密度と容量単価

✔ SMR のメリット

- トラックを重ねて書けるため、同じ枚数のプラッタでより多くのデータを詰める

→ 高い記録密度 を実現 - 同容量であれば部品数は変わらないため、TBあたり価格が低くなる傾向がある。

実例(一般的傾向例):

| 種類 | 容量 | 価格/台 | 価格/1TB |

|---|---|---|---|

| CMR | 4TB | 105$ | 26.25$/TB |

| SMR | 4TB | 95$ | 23.75$/TB |

※ 実売価格は変動しますが、概ねSMRは1TBあたり10〜20%安くなる傾向という観測が存在する。⇒とGPTは答えているが、本当か? ほかにも回転数やサイズなど条件が変わると価格も変わるので、その時点で利用目的も考慮して確認するのが良いでしょう。

📌 容量限界の違い

HDDの記録方式別容量限界の傾向:

- CMR(従来磁気記録): ~16TB級

- SMR: 16〜20TB級(そして28TB/30TB以上のモデルも登場)

これは SMR のトラック密度の高さによるものです。

| 観点 | CMR | SMR |

|---|---|---|

| 現状出荷割合(推定) | 企業・NAS用途で多い | 大容量・アーカイブ用途で増加 |

| 記録密度 | 中〜高 | 高い |

| 容量単価 | やや高い傾向 | やや低い傾向 |

| 性能 | ランダム・更新安定 | ランダム更新で制約あり |

| トレンド | 特定用途で根強い | 大容量需要で伸びている |

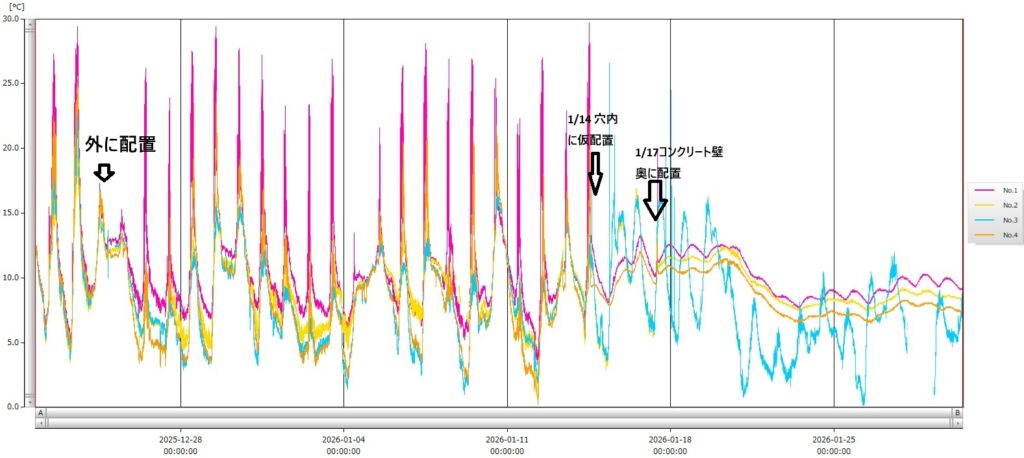

具体的なHDDの選定検討

ここまでの検討結果からの基本方針は、記録方式はSMRではなくNAS向きのCMR、NASの転送速度なら5400rpmで十分で、あとは値段で6TBか4TBかを選択しましょう。現時点(2026年2月時点)の各メーカーのラインナップを確認しました。BARRACUDA、IRONWOLF、でBARRACUDAはこの辺のクラスはSMR方式でした。CMRなのはIRONWOLFです。ということで、シーゲートだと型番はST6000VN006か、ST4000VN006ですね。

WDだと、WD40EZAXですね。

交換用HDDの機種選択の結論

| 型番 | 容量 | 価格 | 1TB単価/補足 |

| Seagate ST6000VN006 | 6TB | 31,400円 | 5233円/NAS向け |

| ST4000VN006 | 4TB | 21,980円 | 5495円/NAS向け |

| Western Digital WD40EFZZ | 4TB | 29,177円 | 7294円/NAS向け |

| WD40EZAX WD40EZZX | 4TB | 21,766円 | 5441円 |

この結果から、ST4000VN006 にすることにしました。この価格は2026/2/23時点のものではありますが、HDDの単価は誰のせいでか、爆上がり中です。本当に買えるかどうかは分かりません。逆に少し待てば、元に戻っている可能性はあります。

それから、SMRとはどういうものなのかが理解され始めたのか、CMRとSMRの価格差が拡大しているようにも感じます。

次回は、購入したHDDを使ってNAS復活に挑戦です。