Windows 11からWindows 11をリモートデスクトップ接続でモヤっとした画面表示になったままどうすることもできない事象が発生している。これに対する対処を検討する。

以前にも「リモートデスクトップのキーボード配置が変わった」問題 があった。リモートデスクトップに関する問題は、数多くのバージョンの組み合わせで使われるので難易度が高い問題でもあるだろう。同じパターンで解決した人がいればコメントください。

いろいろ試して、これかという設定を見つけて対処してみたが今のところ効いていない。今時点で、まだ解決していないが、解決まで話が長くなりそうなのでいったん公開しておきます。 多分解決した(というより、回避できた(モヤッとなるまでの時間が気にならないくらい長く(8時間?くらいは大丈夫)なった)が正しい表現だろう)が、効いたものの1つは明確だが、タイムアウト時間の説明がつかないため何かとの組み合わせで発生していたと推測される。そのため、何との組み合わせなのかは明確には言えない。

まずは、最初(今 )の症状・現状分析から書いていこう。

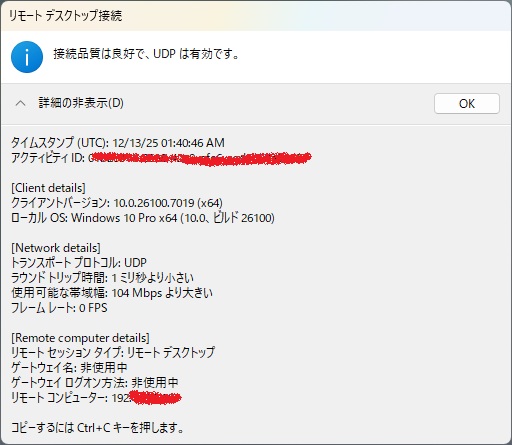

1.問題の症状 このようなモヤっとした画面である。可能な操作は次の通り。接続情報 も見える

おや、Client detailsに想定外の「Windows 10」の文字が。。。。 なぜ? これが原因では? ということで、調べてみた。

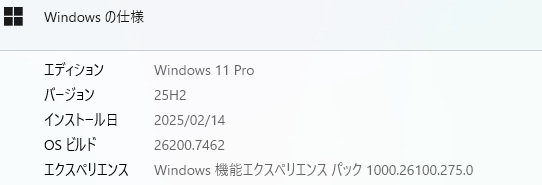

接続先のWindowsは?

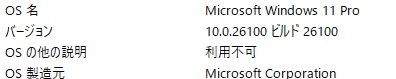

接続元は?

どっちもWindows 11なのに、なぜかリモートデスクトップはWindows 10 これは怪しい。

※ただ、Windows 10のリモートデスクトップに接続したときは、モヤッとならない。

「リモートデスクトップのWindows 11に接続して少し時間がたつとモヤっとなり、接続情報を見るとちゃんと接続しているが、なにも操作できなくなる。ウィンドウを閉じて再接続すると操作はできる。 ウィンドウを閉じて再接続しなくても、操作をできるようにする方法を解説してください。 原因を調べる方法があれば教えてください。」と今噂?のGemini3.0Proに聞いてみた。以下、背景が灰色の部分はGeminiの回答で、赤文字は私のコメントです。

リモートデスクトップ(RDP)接続中に「画面がモヤっとして(画質が低下して)操作不能になる」現象、非常にストレスが溜まりますよね。

この症状の典型的な原因は、RDPが使用している通信プロトコル(UDP)の不調 や、描画キャッシュの不整合 であることが多いです。「接続情報は繋がっている」のに操作できないのは、通信経路の一部(特に画面転送を行うUDP)だけが詰まっている状態と考えられます。

以下に、再接続せずに復帰を試みる方法(対処療法)と、そもそもこの現象が起きないようにする設定(根本治療) 、および原因の調査方法を解説します。

1. 再接続せずに操作可能にする方法(対処療法)画面が固まった際、マウス操作は効かなくてもキーボードショートカットがサーバーに届けば、画面の再描画(リフレッシュ)が走り、操作可能になることがあります。 以下のショートカットを順番に試してみてください。

**Ctrl + Alt + End**: → 効果ありませんでした リモート先で Ctrl + Alt + Del を押したことになります。セキュリティ画面に切り替わることで画面が強制的に再描画され、フリーズが解けることがあります。 **Ctrl + Alt + Break** (または Fn + Break / Pause): → ウィンドウが「全画面表示」と「ウィンドウ表示」が切り替わるだけで操作は復旧せず リモートデスクトップの「全画面表示」と「ウィンドウ表示」を切り替えます。ウィンドウサイズが変わることで画面情報がリセットされ、復帰することがあります。 ※注意: これらで反応がない場合は、通信セッション自体が「ゾンビ状態(切断されているのに認識されていない)」になっているため、残念ながらウィンドウを閉じて再接続するしかありません。

2. 現象を二度と起こさないための設定(根本治療)「モヤっとなる」のは、回線速度に合わせて画質を落とそうとする機能が働いた直後に、通信が詰まっている可能性が高いです。これを防ぐには、「UDP通信を無効化してTCPのみにする」 のが最も効果的です。 方法A:ホスト側(接続される Windows 11)の設定変更これが最も確実です。グループポリシーエディタを使用します(Pro版以上)。 Windowsキー + R を押し、gpedit.msc と入力してEnter。左側のツリーで以下へ進みます。コンピューターの構成 > 管理用テンプレート > Windows コンポーネント > リモート デスクトップ サービス > リモート デスクトップ セッション ホスト > 接続 「RDP トランスポート プロトコルの選択」 をダブルクリックします。「有効」を選択し、オプションで 「TCP のみを使用」 を選択してOKを押します。 PCを再起動します。 →行けそうな気がしたが残念ながら、 効果なし

※ Windows 11 Home版の場合 は、レジストリ操作が必要です。

regedit を起動。HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Microsoft\Windows NT\Terminal Services へ移動。右クリック > 新規 > DWORD(32ビット)値を作成。名前を fClientDisableUDP にする。 値を 1 に設定して再起動。 方法B:クライアント側(操作する手元のPC)の設定変更手元のPCの設定で緩和できる場合もあります。 リモートデスクトップ接続アプリを起動し、「オプションの表示」を開く。 「エクスペリエンス」 タブへ移動。「ビットマップのキャッシュを保持する」のチェックを外す。 キャッシュファイルが壊れて画面がおかしくなるのを防ぎます。 「接続速度の自動検出」 ではなく、「LAN(10Mbps以上)」などに固定してみる。3. 原因を調べる方法なぜ切れるのか、ログを確認して特定する方法です。 イベントビューアーでログを確認するWindowsにはRDP関連の詳細なログが記録されています。 接続される側(Windows 11)または手元のPCで、スタートボタンを右クリック > 「イベント ビューアー」 を選択。 以下のパスを開きます。アプリケーションとサービス ログ > Microsoft > Windows > TerminalServices-LocalSessionManagerOperational → モヤっとなった瞬間のログはない 。 接続情報で、”接続品質が良好”ということとずれはない。 接続はされているが、何らかの制限がかかっているような気がする。「追加情報2」へ

より詳細なエラー理由は以下を確認します。アプリケーションとサービス ログ > Microsoft > Windows > TerminalServices-ClientActiveXCoreMicrosoft-Windows-TerminalServices-RDPClient/Operational お

ここで「警告」 や「エラー」 になっている項目のIDやメッセージ(例:ID 1026 ネットワーク接続が失われました 等)を確認します。 ここにでてますね

パケットロスを確認する接続中にコマンドプロンプトを開き、以下のコマンドを打ちっぱなしにしておきます。 ping -t [接続先IPアドレス]

画面が「モヤっと」して操作不能になった瞬間、pingも Request timed out になっていれば、PCの問題ではなくネットワーク機器(ルーターやWi-Fi)の瞬断が原因です。

まとめ:まず試していただきたいことまずは、「UDP通信の無効化(TCP固定)」 を行ってみてください。 「モヤっとなる(画質低下)」現象は、UDP通信特有の症状であることが多いため、TCPに固定することで画質の変動はなくなり、通信の安定性が向上する可能性が非常に高いです。

レジストリやポリシーの設定変更について、より詳細な手順のサポートが必要ですか?

すでに有線LAN接続をしている。 ただ、モヤっとしないほうに比べて距離が遠い

あいだに ルータはない。 スイッチングハブのみ 。 とここで、次の情報を発見追加情報2 更新プログラムの適用

Windows Updateで最新の累積更新を適用(2025年3月以降の更新でRDP関連の不具合が修正済み) 接続先PC側 と 接続元と、 どちらのアップデートで、 効果がありますか? 。

更新の影響範囲 接続元PC(クライアント側) RDPクライアント( や ActiveXコンポーネント)の不具合修正は 接続元側の更新 で効果が出ます。 特に「マルチトランスポート(UDP/TCP併用)」関連の修正はクライアント側に依存するため、接続元を最新にすることが重要です。 接続先PC(サーバー側) RDPサービス()やグラフィック描画、セッション管理の修正は 接続先側の更新 で効果があります。 サーバー側が古いと、クライアントが最新でも描画が乱れたり切断が発生することがあります。 ✅ 実際の対策 両方のPCを最新にするのがベスト クライアント側だけ更新しても改善するケースはありますが、サーバー側が古いと再発しやすいです。 パッチ情報を確認 ✅ 確認方法のステップ

Windows Updateの更新履歴を確認 「設定」 → 「Windows Update」 → 「更新履歴」を開く インストール済み更新プログラムの一覧から KB5053656(2025年3月27日公開) または KB5053598(2025年3月定例更新) があるか確認 これらが表示されていれば、リモートデスクトップの「モヤ」問題は修正済みです。

→ クライアント側は KB5053598 は 2025/3/18に正しくインストールされている 。ので、これではないようだ。 おや、接続される側にはない? このマシンは2025/2/19~2025/4/11まで起動しなかったのでパッチ適用されず解消されていないのかもしれない。Microsoft Update Catalog にアクセスして、「KB5053656」または「KB5053598」で検索すればよいようだ。

累積更新の世代違い 3月の KB5053598 は既に古く、25H2 では 4月以降の累積更新 (例: KB5055523, KB5067036) が必要です。 →なにそれ、「最新の状態です」と出ているのに… Microsoft Update Catalog からKB5067036を検索して、 2025 年 10 月の累積更新プログラムのプレビュー (Windows 11, version 25H2、x64 ベースのシステム向け) (KB5067036) (26200.7019) を選択し適用を試みる

KB5067036 の内容は 11月の累積更新 KB5068861 に統合されています。

なんと、 現在は 26200.7462 なので、すでに適用済みだと..?

OSビルド番号を確認 → 「winver」と入力 表示されたビルド番号を確認 修正済みの目安: KB5052093 適用後 → 26100.3323 以上 KB5053656 適用後 → さらに安定版(2025年3月末以降) コマンドラインで確認(管理者向け) PowerShellで以下を実行: 出力に KB5053656 や KB5053598 が含まれていれば適用済み。 📌 補足情報

問題の原因は2025年1月~2月の更新(KB5050094, KB5051987)で発生した既知の不具合。 Microsoftは 2025年3月以降の累積更新(KB5053598, KB5053656, KB5055523など)で修正済み。 企業環境でWSUSやWUfBを利用している場合は、3月以降の累積更新を承認していれば同じ効果が得られます。 👉 まとめると、「更新履歴」でKB番号を確認するか、「winver」でビルド番号が26100.3323以上になっているか」を見れば、パッチ適用済みかどうか判断できます。

仕切り直し ここまでの結果、AIでは? AIでもそう簡単に解決できる問題ではないことが判明した。再度、論理的に考え直してみよう。「リモートデスクトップのキーボード配置が変わった」 件とすごく似ている感じがします。あのときは、レジストリ設定をいろいろ変更しました。

それから、挙動から、グラフィック処理周りの設定が怪しそうです。接続情報で「接続品質が良好」なのに操作不能になるのは、通信ではなくグラフィックレンダリング層での問題 である可能性が高いと推測されます。

関連する設定の確認と変更検討 # 1. グラフィック処理の最適化を無効化 管理者権限のターミナルで上の設定を実施、レジストリエディタで更新されていることを確認して、再起動した。 とりあえずこれで様子見だったが、 すぐに発生した。

# 1. 接続先PCのGPUドライバー情報確認 # 接続先PC(25H2)で以下を確認 d:

Name DriverVersion DriverDate

PS D:> winver

WNSUriRegName : {85, 248, 12, 164…}

PS D:> Get-HotFix | Where-Object {$_.InstalledOn -gt (Get-Date).AddMonths(-2)} |

Format-Table HotFixID, Description, InstalledOn

HotFixID Description InstalledOn

-. NVIDIA RTX 3080のドライバーが古い ?

DriverVersion: 32.0.15.6094 (2024年8月14日)

Driver Version: 560.94 (最新版)実はドライバーは既に最新

対策1: GPUハードウェアアクセラレーションの無効化(最優先)

接続先PCで実行:

# 1. RDP専用のGPU制御設定 ほぼ設定済みだが

# 1. GPU制御の無効化(最重要) 上の設定をしたがだめ、

# Desktop Window Manager (DWM) のログを有効化 # Desktop Window Manager (DWM) のログを有効化 $logTime = (Get-Date).AddMinutes(-5) ———————– # 接続先PCで実行 次を実施

とりあえず、これで様子見ですが、すぐにモヤっとが再発しました。 他のログと混ざらないように、少し時間をおいて次の調査作業に入りましょう。

この状態でスリープさせることは確認できていますが、 何らかのキー操作で復活させることはできないか検討してみましょう。

モヤっとリモートデスクトップにポインチが当たっているときは、

もちろん「モヤっとのリモートデスクトップ」にpointが当たっていないときはその他のウインドウは動く。まるで、サインインの前の状態のように…?お?

・一旦リモートデスクトップを閉じます。 うーーむ 、モヤっとでストップ状態が再発した、 本当にサーバ側なのか? クライアント側にも要因があったりしないか?

対策: 一時的にTCPのみで接続するように設定します。 クライアント側のWindows Updateで KB5052093 (またはそれ以降の累積更新)が適用されているか確認

接続元PC: Windows 11 25H2 (26200.7462) – KB5052093 未適用

接続元 # 接続元PCで実行 接続先

# 接続先PCで実行(まだ未設定のもの) ウームどれも効かない

この件を、直そうとしていろいろトライしていたら、テキストコピーができなくなった。 まずモヤっと問題と関連があるか調査が必要だが、作業効率を考えると、こっちを優先して対照する必要がある。こっちを優先して対応することにする。

追加確認調査 PS C:\Users> # RDPクライアントのバージョン確認

VersionInfo : File: C:\Windows\System32\mstsc.exe

PS C:\Users>

VersionInfo : File: C:\Windows\System32\mstscax.dll

RDPクライアントのバージョンが 26100.7306 となっていますが、これは 24H2(旧バージョン) のものです。

現在のOSビルドは 26200.7462(25H2) なのに、RDPクライアントだけ古いバージョンのまま 残っています。これが「接続情報にWindows 10と表示される」原因であり、モヤっと問題の根本原因の可能性が高い?

sfc /scannow Restart-Computer リモートデスクトップに接続しようとしたら

エラーコード:0x3

拡張エラー コード:0x19

タイムスタンプ(UTC):12/19/25 04:35:51 AMのダイアログが出た。 そしてリモートデスクトップに接続できない状態のとなったため、サーバー側で次の対処を実施した。

SFC実行で何かのグラフィック関連ファイルが変更され、問題が悪化した可能性があります。 とりあえず、うえの対処でリモートデスクトップ接続が回復した。

状況再確認. リモート デスクトップ接続 の状態を再確認すると、バージョンが上がっていた。sfc /scannow の対処が効いたのかも

リモート デスクトップ接続26100.7309 とりあえず、これで様子見です。→ これでもやはり再発しました。

改めて状況を整理 OSビルド:26200.7462(25H2)✅ 正常 mstsc.exe:26100.7306 ✅ 正常 Win11 → Win11:モヤっと発生 ❌ Win11 → Win10:問題なし ✅ とここで。気が付いた。「Win11 → Win10:問題なし」ですが、モヤっとはなる。

新しい理解

Win10接続:モヤっとになる → ログイン画面が表示される → 再ログイン可能 ✅

つまり、「モヤっと」自体はセッションがロックされた状態であり、問題は:

これで説明がつくこと 接続品質は良好(通信は正常) スリープはできる(コマンドは届く) Win+Tab、電源メニューは反応(一部の操作は有効) しかし画面入力ができない(ロック解除の画面が出ていない) Ctrl + Alt + End を押す(リモート側のCtrl+Alt+Del相当)→これは効かなかった。

【対策】Known Issue Rollback(KIR)を適用(根本解決)接続先PC(サーバー側) で実行:

# 管理者権限のPowerShellまたはコマンドプロンプトで実行 残念ながら、上の設定では対処できなかった。

似たような別の問題の可能性は?

仮説 スクリーンセーバー → ロック画面に移行 Win11 25H2のバグ で、リモートデスクトップ経由のロック画面描画に問題がある → モヤっと状態で操作不能

解決策 スクリーンセーバーを完全無効化 →とりあえず、この設定で確認 →これでも解決できず

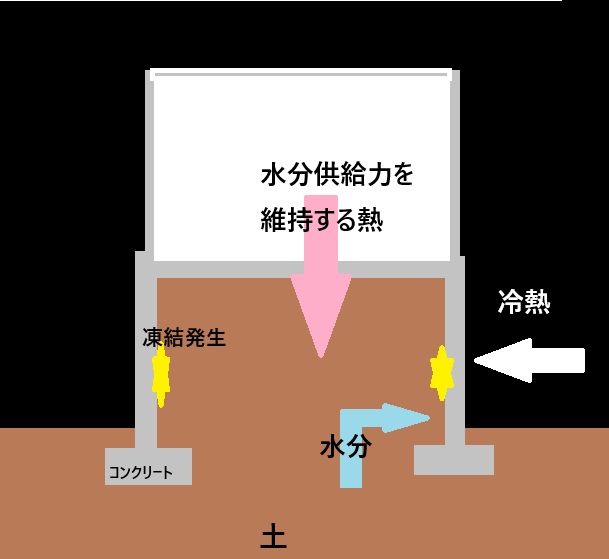

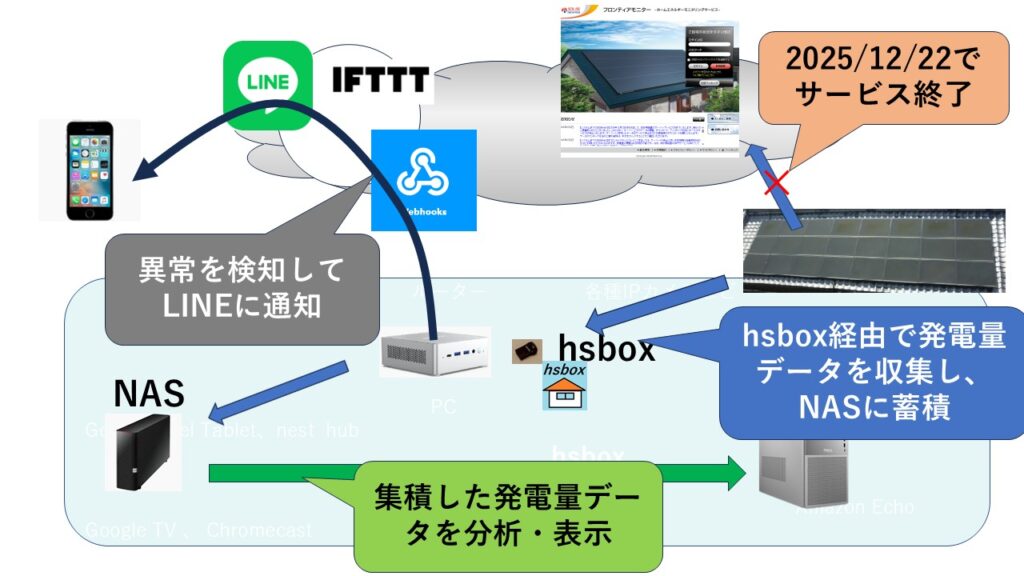

新たな仮説 ヘッドレス環境(ディスプレイなし)の問題

物理ディスプレイなし = GPUが「アクティブな出力なし」と判断

Win10では問題ない理由:

Win10のグラフィックスタックは古い仕組み

対策案仮想ディスプレイを有効化(ソフトウェア対応) **接続先PC(サーバー側)**で:

# Microsoft Remote Display Adapterを常に有効化 再度、これで様子見です→ これでも回避できず。。

【対策】NVIDIA GPUの電源管理を無効化 接続先PC(サーバー側) で:

# NVIDIAコントロールパネル設定(GUIで) おや、これ(NVIDIA GPUの電源管理を無効化)は効いている →半日経過しても発生しなかったので回避できたと判断する。

具体的な問題発生回避状況は、時間経過してもRDPはスクリーンセイバーや画面ロックは発生せず、正常表示のままだ。 問題発生時はフォーカス(ポイント)がRDPのウインドウから外れて5分でモヤっとしており、多分ヒントは5分のタイムアウトにありそうだが、5分(300秒)程度のタイムアウト設定は見つけれていない。

この辺をヒントに試してください。 何かあればコメントください。

関連記事